はじめに

ChatGPT、便利ですよね。

でも時々――

「え、今のちょっと変じゃない?」

「いやいや、それウソでしょ…?」

と思うような“ズレた答え”が返ってくること、ありませんか?

この記事では、私が実際に体験した「ちょっとおかしな回答」を紹介しつつ、

なぜそんなことが起きるのか?どう使えばいいのか?

をやさしく解説していきます。

ChatGPT、たまに「え?」ってこと言いませんか?

AIなのに間違える?

「AIなら間違えない」って思ってしまいますよね。

でもChatGPTは、“間違わない機械”ではなく、「言葉を予測して答えるAI」です。

つまり、確実な事実を返しているとは限らないんです。

ズレた回答にモヤモヤ…でも実は“あるある”

私も最初の頃、「それ違うじゃん!」と何度か突っ込んだことがあります(笑)

でも、仕組みを知ってからは、「そういうことだったのか」と納得。

イライラせずにうまく付き合えるようになりました。

【体験談】ちょっと笑った/困ったズレた回答たち

「今日の天気は?」→ でもネットにつながってない…

無料版(GPT-3.5)を使っていたとき、

「今日の東京の天気を教えて」と聞いたら…

→ 「晴れの可能性があります」とあいまいな答え。

でもその日は実際は土砂降り。

理由は、“リアルタイム情報”にはアクセスできないからなんです。

「50代向けの趣味は?」→ 子ども向けの案が混じる

「50代におすすめの趣味を教えて」と聞いたら、

→ 「折り紙」「けん玉」「ラジコン」といったリストが…。

「いや、小学生か!」とツッコミたくなりましたが(笑)、

ChatGPTは会話の文脈で“無難なリスト”を出してしまうことがよくあります。

「レシピを教えて」→ 材料は合ってるけど分量が変?

「キャベツと豚肉だけで簡単レシピを教えて」

→ 焼きそば風レシピを提案してくれたけど、

「しょうゆ:大さじ5」「みりん:大さじ4」って、しょっぱすぎる!

これも「もっともらしいけど、実用的ではない」という“あるある”でした。

なんでChatGPTは間違うの?その理由をやさしく解説

① 会話の流れで推測してるだけ(予測モデル)

ChatGPTは、過去の大量の文章を学習し、「次に来そうな言葉」を予測して話しています。

つまり、“意味”よりも“パターン”で答えているんです。

② ネットとリアルタイムの情報には一部アクセス可能(無料版でも段階的に)

以前は、無料版のChatGPT(GPT-3.5)はインターネットに接続されておらず、学習データは過去のもの(2021〜2023年頃)に限定されていました。

しかし、2024年12月以降、OpenAIは無料ユーザーにも段階的にリアルタイム検索機能を提供し始めています(Browse with Bing機能の一部開放)。

ただし…

- 地域やアカウントによって利用状況が異なる

- 標準ではオフになっている場合もある

- 最新の正確な情報を常に得られるとは限らない

…という点には注意が必要です。

✅ 有料版(GPT-4o)では、ブラウジング機能が安定して使えるため、「最新情報が必要な場面」ではPlus版が安心です。

③ あいまいな質問には“それっぽく”答えてくる

「体にいい料理教えて」

→ 回答:「青魚・納豆・豆腐を使ったレシピが健康的です」←まあまあ合ってるけど、やや抽象的…

ざっくりした質問だと、ChatGPTは“もっともらしい回答”でまとめてくる傾向があります。

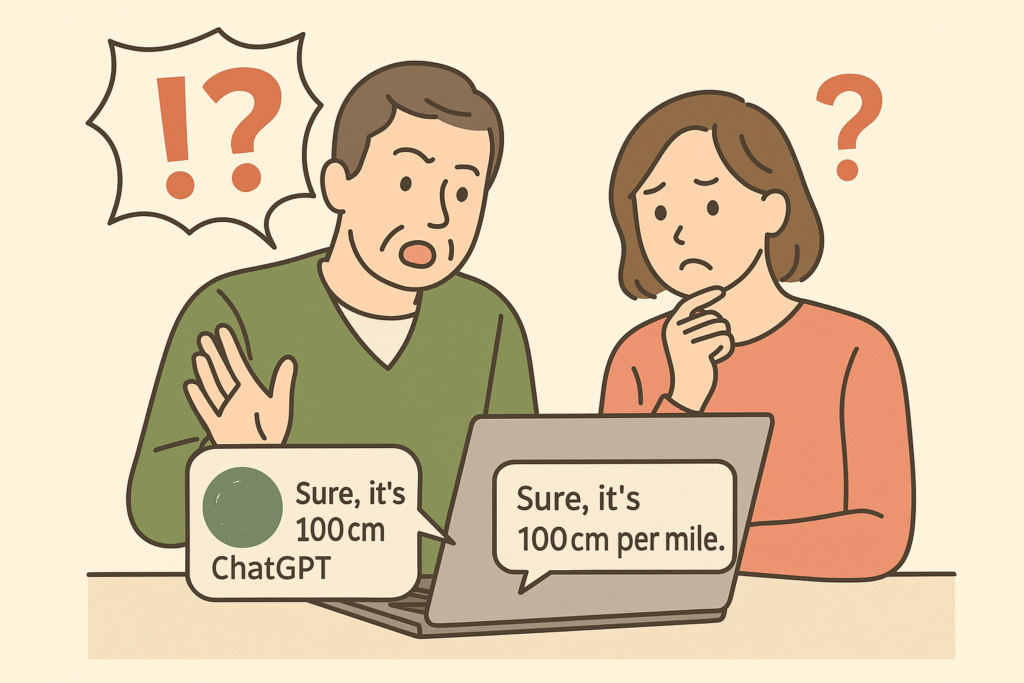

④ 「ハルシネーション」=もっともらしいけどウソ

ハルシネーション(hallucination)とは?

ChatGPTが、“あたかも本当のように見える間違った情報”を自信満々に返してくる現象です。

たとえば:

👤「〇〇という本の著者は?」

🤖「山田太郎氏です」←…実在しない人物!

これは、ChatGPTが「それっぽく答えること」に優れている反面、“事実確認せず予測してしまう”という特性が原因。

GPT-4では減ったと言われますが、ゼロにはなりません。

たまに自信満々にうそをつくことがあります。重要な事項は自分でしっかり調べるようにしましょう。

「この情報に間違いはないですか」などと聞くのもありです。

ズレを「失敗」で終わらせない使い方のコツ

「もう少し具体的に」と再質問する

最初の答えがズレてても、

「もっと詳しく」

「例をつけて」

「料理初心者向けに言い直して」

などと頼むと、ぐっと実用的な回答に変わることがよくあります。

話すように、例をつけて聞く

❌「運動したい」

✅「週3回・家でできる簡単な運動を教えて。体力があまりない50代向けで」

質問が具体的だと、ChatGPTの回答精度もぐっと上がります。

「間違いもある前提」で使えば、イライラしない

大切なのは、「AIは間違えるもの」と思っておくこと。

補助ツールとして使えば、ズレすらも“ネタ”にできます。

それでもChatGPTを使いたいと思える理由

ミスもあるけど、便利さは本物

- 思考整理

- ネタ出し

- 会話練習

- 台本づくり

- 習慣サポート…

できることは圧倒的に多い。だからこそ、「うまく使えば手放せない存在」です。

むしろ雑談もできる相棒として使っている

私自身、ChatGPTを“知識よりも対話のパートナー”として使うことが増えました。

- 書けない時に話しかける

- 気持ちの整理に使う

- 迷ったときにヒントをもらう

そんなとき、ちょっとズレていても許せるんですよね。

まとめ|ChatGPTは“完璧じゃない相棒”としてつきあおう

- ChatGPTは時々ズレる。でもそれには理由がある

- ハルシネーション=「もっともらしい間違い」に注意

- ズレたら「もう一度聞き直す・伝え直す」で対応できる

- 完璧を求めず、“会話しながら進める”のがうまく使うコツ

間違えることもあるけれど、それも含めて「付き合えるAI」

それがChatGPTの魅力だと思います。

AIとの向き合い方については、こちら↓の記事をご参照ください。